Как современные технологии могут украсть… лицо

Специалисты Fingramota.kz разобрались, как это работает и можно ли защититься от атак высоких технологий.

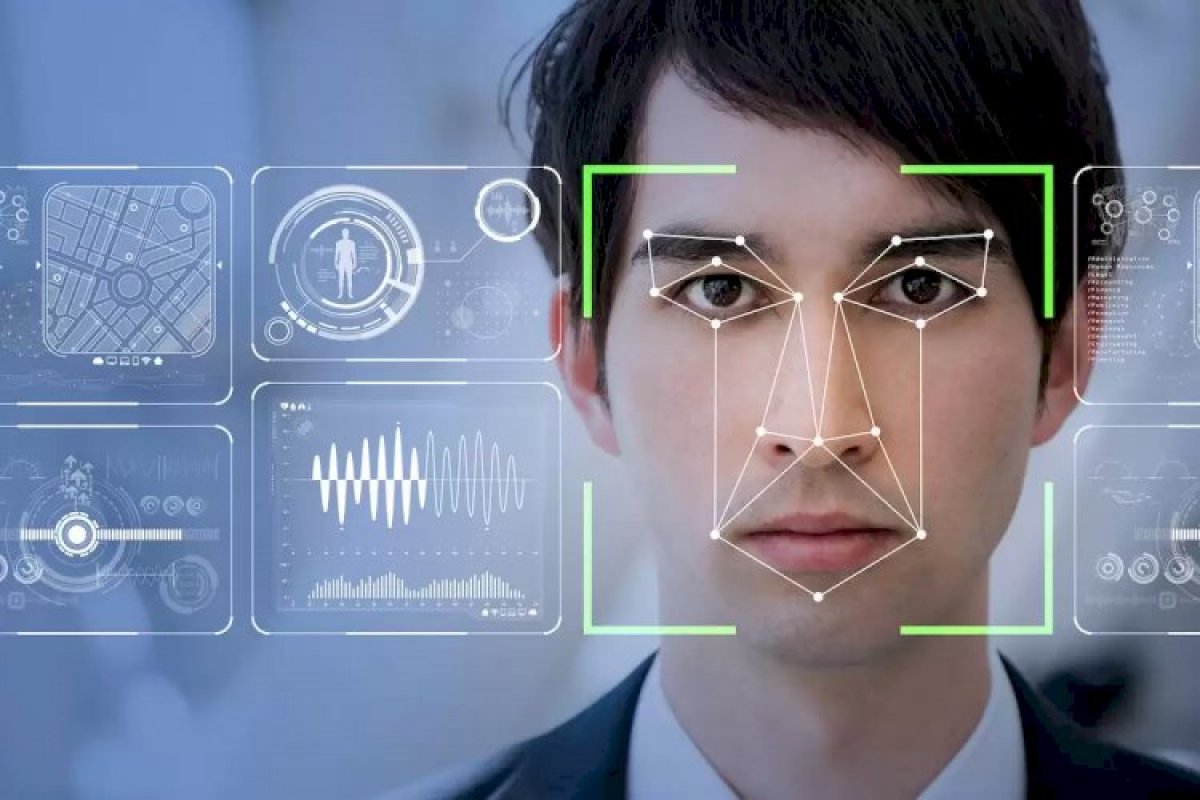

Копировать и оживлять лица может такое приложение, как дипфейк, – это фото-, видео- или аудиозапись, обработанные с помощью искусственного интеллекта. Термин «deepfake» произошел от двух слов – «глубокий» и «фальшивый».

Данная технология позволяет оживить несуществующих персонажей либо использовать лица других людей, подделать любой голос, мимику, добавить в речь слова, которые человек никогда не произносил. Это стало идеальным инструментом в руках мошенников для совершения кибератак и краж конфиденциальных данных граждан.

Специалисты Fingramota.kz разобрались, как это работает и можно ли защититься от атак высоких технологий.

– Технология дипфейков основана на мощнейших нейросетях, с помощью которых можно генерировать любые фото- и видеоизображения, манипулировать такими биометрическими данными, как тональность голоса, выражение лица человека. Благодаря дипфейкам можно создавать события, которые никогда не происходили, добавить возраст человеку или, наоборот, сбросить ему несколько десятков лет, доснять фильм с актером, которого нет в живых, оживить фотографию. Этим активно пользуются продюсеры, режиссеры, маркетологи, рекламщики и… мошенники, – поясняют эксперты.

С помощью дипфейков злоумышленники могут подделать чужую личность, для того чтобы получить доступ к банковскому счету, обналичить его и оформить подставные кредиты. Могут выкрасть данные умершего человека, «оживить» его для получения доступа к банковским онлайн-сервисам или вовсе синтезировать новую персону, которой не существует в природе, используя ее для совершения крупных финансовых транзакций и изощренных схем кредитного мошенничества.

Дипфейки стали использоваться сравнительно недавно, в интернете поддельные видео на основе этой новейшей технологии появились пять лет назад, а в 2019 году прогремела первая в мире крупная афера. В Великобритании киберпреступники с помощью искусственного интеллекта подделали голос главы крупной энергетической компании и даже его легкий немецкий акцент. Они позвонили исполнительному директору и под предлогом срочности потребовали перевести 220 тыс. евро в течение часа якобы поставщику. Управленец выполнил указание своего «босса», но мошенники на этом не остановились и позвонили еще два раза с просьбой совершить дополнительные платежи. Это вызвало подозрения.

В результате расследование показало, что была совершена тщательно продуманная хакерская атака с использованием фейкового аудио, но вернуть средства, как и найти злоумышленников, не удалось.

В 2020 году жертвой мошенников чуть не стал 68-летний адвокат из Филадельфии, который почти поверил звонившему «сыну». Мошенники использовали дипфейк-аудио молодого человека и позвонили его отцу с просьбой перевести 9 тыс. долларов, но, к счастью, афера была вовремя раскрыта.

В Китае уличили во лжи аферистов, выдававших своим клиентам поддельные накладные. Они покупали фотографии людей и «оживляли» их с помощью технологии дипфейка, чтобы пройти систему проверки личности налоговой службы. Таким образом преступники заработали свыше 76 млн долларов.

В Казахстане о случаях мошенничества с использованием технологии дипфейка пока неизвестно, но, как говорится, предупрежден – значит, вооружен.

– Основным способом борьбы с киберпреступниками, использующими дипфейки, является повышение осведомленности пользователей о подобной схеме обмана и соблюдение цифровой гигиены, – утверждают специалисты.

Мошенники редко уделяют должное внимание качеству своего «продукта», будь то видео, фото или аудио. Поэтому странное моргание человека либо его отсутствие, слова невпопад, легкое заикание или роботизированный тон должны вас насторожить. Ко всему, что кажется неестественным, надо отнестись с подозрением.

Если звонит близкий или знакомый и просит срочно перевести деньги, завершите разговор и перезвоните ему сами. Уточните, действительно ли он звонил вам, а не мошенники.

В интернете увидели ролик, в котором публичная личность предлагает вам заработать много денег при минимальных усилиях, – перепроверяйте информацию, тем более что гарантированный и быстрый доход обещают только мошенники.

– Подобным «рекламам», даже без дипфейков, где просто используются изображения известных и уважаемых людей, не нужно доверять. Злоумышленники сегодня активно предлагают заработать на различных инвестиционных онлайн-платформах, для участия в которых нужно оставить свои данные на фейковых сайтах и перечислить организаторам небольшие суммы. Будьте аккуратны, мошенники обещают золотые горы, а взамен оставляют своих жертв у разбитого корыта. Теперь они могут делать это не напрямую, а через искусственный интеллект. Некоторые сервисы могут создать дипфейк-видео или аудио, пусть и не очень хорошего качества, только с помощью одного изображения или голосовой записи длиной в несколько секунд, – отмечают эксперты.

Поэтому, чтобы не попасться на уловки кибермошенников, стоит соблюдать простые правила безопасности в интернете и проявлять внимательность при любых обстоятельствах.

Хочешь получать главные новости на свой телефон? Подпишись на наш Telegram-канал!

Хочешь получать главные новости на свой телефон? Подпишись на наш Telegram-канал!